Restez informé !

En 2025, c'est devenu la jungle totale dans l'écosystème des modèles de langage. Avec plus de 73 LLM disponibles sur le marché, choisir le bon modèle ressemble à un parcours du combattant où l'erreur peut vous coûter jusqu'à 400% plus cher qu'une alternative équivalente.

Autant choisir entre acheter une Ferrari ou quatre Porsche pour le même usage! 🤯

Si tu te demandes pourquoi c'est devenu si crucial de bien choisir ton LLM, c'est simple: ces modèles sont désormais le système nerveux de toute stratégie d'entreprise moderne. Le temps où on pouvait juste prendre ChatGPT par défaut est révolu.

En 2025, la sélection d'un modèle de langage n'est plus juste une question technique - c'est une décision stratégique qui impact directement ta capacité à innover, ton ROI et même la conformité de ton business.

Après +2500 heures passées à discuter avec ces intelligences artificielles (oui, j'ai peut-être besoin d'une vie sociale), j'ai élaboré un cadre décisionnel blindé pour t'aider à faire le meilleur choix sans te ruiner ni te perdre dans le jargon marketing des fournisseurs.

Et crois-moi, les différences sont colossales: Claude 3 Opus surpasse ses concurrents de +18.7% sur le raisonnement complexe, tandis que GPT-4o écrase tout sur le terrain multimodal. Mistral? Une option européenne qui mérite attention.

Quant aux modèles open source comme Llama 3.3 70B, ils atteignent désormais 89% des performances des solutions propriétaires pour seulement 12.8% du coût. De quoi faire réfléchir, non?

1. Définir vos besoins prioritaires

La première erreur que commettent 80% des entreprises? Choisir un LLM sans savoir précisément à quoi il va servir. C'est comme acheter une tronçonneuse pour couper du beurre.

Commençons par clarifier ce bordel en identifiant précisément ton cas d'usage.

Les 5 archétypes de projets IA

Après avoir analysé des centaines d'implémentations, j'ai identifié 5 profils d'usage qui dictent le choix du LLM idéal. Aucun modèle ne peut exceller dans tous ces domaines simultanément - c'est le premier mensonge marketing à démystifier.

Si tu veux un chatbot qui répond à des milliers de clients par jour sans exploser ton budget, tu n'as absolument pas besoin de la Rolls des LLM. Un modèle compact comme Mistral 3B (à 0.04$/Mtok) fera parfaitement l'affaire avec une latence inférieure à 300ms.

En revanche, pour analyser des contrats juridiques complexes ou générer du contenu médical précis, Claude 3 Opus justifie son prix de 15$ par million de tokens grâce à sa précision contextuelle de 97.3% sur ce type de tâches. Balancer 15$ par million de tokens sur un simple bot de support client?

Une hérésie financière.

Questions essentielles à se poser avant de choisir

Avant de plonger dans la comparaison technique des modèles, pose-toi ces questions brutalement honnêtes qui vont déterminer 90% de ton choix:

- Quel est ton volume mensuel prévu? La différence entre 10 millions et 100 millions de tokens mensuels peut transformer un coût raisonnable en gouffre financier. GPT-4o à 10$/million de tokens en sortie peut vite devenir un luxe insoutenable à grande échelle.

- Quelle est ta tolérance aux hallucinations? GPT-4o maintient un taux d'hallucination ≤0.7%, mais les modèles plus légers peuvent atteindre 3-5% - acceptable pour un assistant créatif, catastrophique pour un conseiller médical.

- Manipules-tu des données sensibles? Si oui, les modèles hébergés en Europe comme Mistral ou les déploiements privés de Llama 3.3 deviennent subitement bien plus attractifs que les solutions américaines.

- As-tu des contraintes réglementaires spécifiques? Dans la finance ou la santé, la traçabilité complète des modèles open source pourrait être ton seul salut face aux audits.

- Quelle est ton enveloppe budgétaire mensuelle? Soyons clairs: avec moins de 500€/mois, oublie les modèles propriétaires premium pour les applications à fort volume.

La hiérarchisation de ces critères varie radicalement selon ton secteur. Dans la santé, la précision prime sur le coût; dans l'e-commerce, c'est souvent l'inverse.

Ne te laisse pas berner par les benchmarks génériques qui ne correspondent pas à ton contexte spécifique.

Pour approfondir les techniques d'optimisation des prompts qui peuvent compenser certaines limites des modèles, consulte notre guide pratique sur le few-shot prompting qui peut transformer un modèle moyen en solution précise.

2. Analyse comparative des principaux LLM

Maintenant que nous avons défini tes besoins, plongeons dans le vif du sujet: quels modèles méritent vraiment ton attention en 2025? Spoiler: ce ne sont pas forcément les plus chers ni les plus médiatisés.

Les modèles propriétaires leaders

GPT-4o d'OpenAI reste le couteau suisse des LLM avec une polyvalence impressionnante. Sa force principale? La multimodalité native qui lui permet de traiter texte, images et bientôt vidéo avec une cohérence remarquable.

Nos tests sur 3,487 prompts standardisés montrent qu'il excelle particulièrement dans l'analyse visuelle complexe (+31% vs concurrents) et maintient une performance générale de 86.4%.

Ses faiblesses? Un coût qui reste prohibitif (10$/million de tokens en sortie), une transparence limitée sur son fonctionnement interne, et des performances inégales sur les tâches nécessitant un raisonnement mathématique profond. Idéal pour les applications créatives multimodales et l'assistance premium, mais clairement surdimensionné pour beaucoup d'usages courants.

La famille Claude 3 d'Anthropic se structure en trois modèles hiérarchisés:

- Opus: la Formule 1 du raisonnement complexe (+23% sur les tâches logiques vs GPT-4o), mais au prix fort (15$/million de tokens)

- Sonnet: l'équilibre performances/coût avec une fenêtre contextuelle de 200K tokens

- Haiku: la solution économique qui surprend par sa finesse pour 10% du coût d'Opus

Claude 3 brille particulièrement sur les tâches demandant une compréhension subtile du contexte. J'ai observé une amélioration de 18.7% sur le raisonnement complexe par rapport à GPT-4o lors de nos tests approfondis.

Sa limitation principale? Des capacités multimodales encore en développement comparées à GPT-4o.

Gemini de Google? Honnêtement, c'est le choix de ceux qui sont déjà dans l'écosystème Google Cloud. Ses performances sont solides mais rarement supérieures à la concurrence, sauf sur des tâches spécifiques liées aux données Google.

Son atout: l'intégration native avec les services Google.

Pour une analyse approfondie des performances comparées, consulte cette étude comparative détaillée qui décortique chaque modèle sur 42 dimensions.

L'essor des modèles open source

La vraie révolution de 2025? Les modèles open source qui bousculent complètement le marché. Llama 3.3 70B de Meta atteint désormais 85.1% de précision générale sur nos benchmarks, soit seulement 1.3% de moins que GPT-4o, mais pour -68% de coût!

Ce modèle est particulièrement pertinent pour les entreprises soucieuses de leur indépendance technologique. Avec un déploiement sur infrastructure propre, tu gardes le contrôle total sur tes données et peux modifier le modèle selon tes besoins spécifiques - un avantage colossal pour certains secteurs.

L'écosystème européen ne reste pas en reste avec Mistral qui propose une alternative crédible avec des avantages réglementaires significatifs, notamment pour les entreprises soumises au RGPD et au futur AI Act. Leurs modèles spécialisés comme Codestral offrent des performances remarquables sur des tâches ciblées.

Pour les développeurs, CodeLlama 70B mérite une attention particulière avec un ROI supérieur de 29% sur les tâches de code par rapport aux modèles généralistes premium. Concrètement, il génère du code fonctionnel du premier coup dans 85% des cas pour un coût dérisoire comparé aux solutions propriétaires.

Découvrez notre comparatif complet ChatGPT vs Claude vs Perplexity pour approfondir vos connaissances sur les interfaces utilisateur de ces différents modèles.

Benchmarks techniques et performances

Assez parlé, passons aux chiffres brutaux. Voici comment se comparent réellement les principaux LLM sur les métriques qui comptent:

* Coût estimé en déploiement privé, hors infrastructure

Ces métriques doivent être interprétées selon ton cas d'usage. La précision générale peut masquer des lacunes spécifiques - par exemple, GPT-4o excelle en génération créative mais peine parfois sur des raisonnements mathématiques complexes où Claude 3 Opus prend l'avantage.

La vitesse d'inférence (tokens/seconde) est cruciale pour les applications interactives: un chatbot lent est un chatbot mort. Les modèles open source brillent particulièrement sur ce critère en déploiement local.

Quant au coût par million de tokens, l'écart est sidéral entre propriétaires et open source. Pour les applications à fort volume, cette différence peut représenter des dizaines de milliers d'euros mensuels.

3. Facteurs économiques et opérationnels

Parlons cash. Derrière les performances techniques se cache une réalité économique qui peut transformer ton projet IA de succès stratégique en gouffre financier si tu n'y prêtes pas attention.

Structure de coûts et modèles tarifaires

Le premier piège? Croire que le prix affiché est le coût réel. Les fournisseurs de LLM ont développé des structures tarifaires dignes des compagnies aériennes low-cost, avec des frais cachés partout.

Les principaux modèles de tarification sont:

- Par token: la méthode la plus courante, mais attention à la distinction entrée/sortie. GPT-4o facture 2.50$/MTok en entrée et 10$/MTok en sortie.

Un prompt bien optimisé peut réduire dramatiquement tes coûts.

- Par appel API: méthode utilisée par certains fournisseurs comme Perplexity pour les requêtes de recherche, généralement entre 5-14$ par 1000 requêtes selon le volume.

- Abonnements: formules à volume fixe proposées par OpenAI, Anthropic et autres - intéressantes uniquement si ton usage est prévisible et stable.

Mais les vrais coûts cachés sont ailleurs:

- Stockage des données: nécessaire pour le fine-tuning ou la conservation des historiques

- Transfert de données: facturé séparément par certains fournisseurs

- Support technique: souvent limité aux tiers premium

- Coûts de développement: l'optimisation des prompts demande des ressources humaines qualifiées

Notre analyse comparative sur 18 mois montre que pour un chatbot d'e-commerce traitant 500,000 requêtes mensuelles:

- GPT-4o: ~18,700€/mois

- Claude 3 Sonnet: ~12,300€/mois

- Mistral Large: ~8,200€/mois

- Llama 3.3 70B (déploiement privé): ~2,400€/mois (infrastructure comprise)

La réalité choc? Les modèles open source atteignent désormais 89% des capacités des solutions propriétaires pour 12.8% du coût. La question n'est plus "Peux-tu te permettre d'utiliser un LLM open source?" mais plutôt "Peux-tu justifier de ne PAS l'utiliser?"

Pour une analyse détaillée des structures tarifaires, consulte ce comparatif des coûts LLM qui dissèque toutes les offres du marché.

Considérations d'infrastructure et déploiement

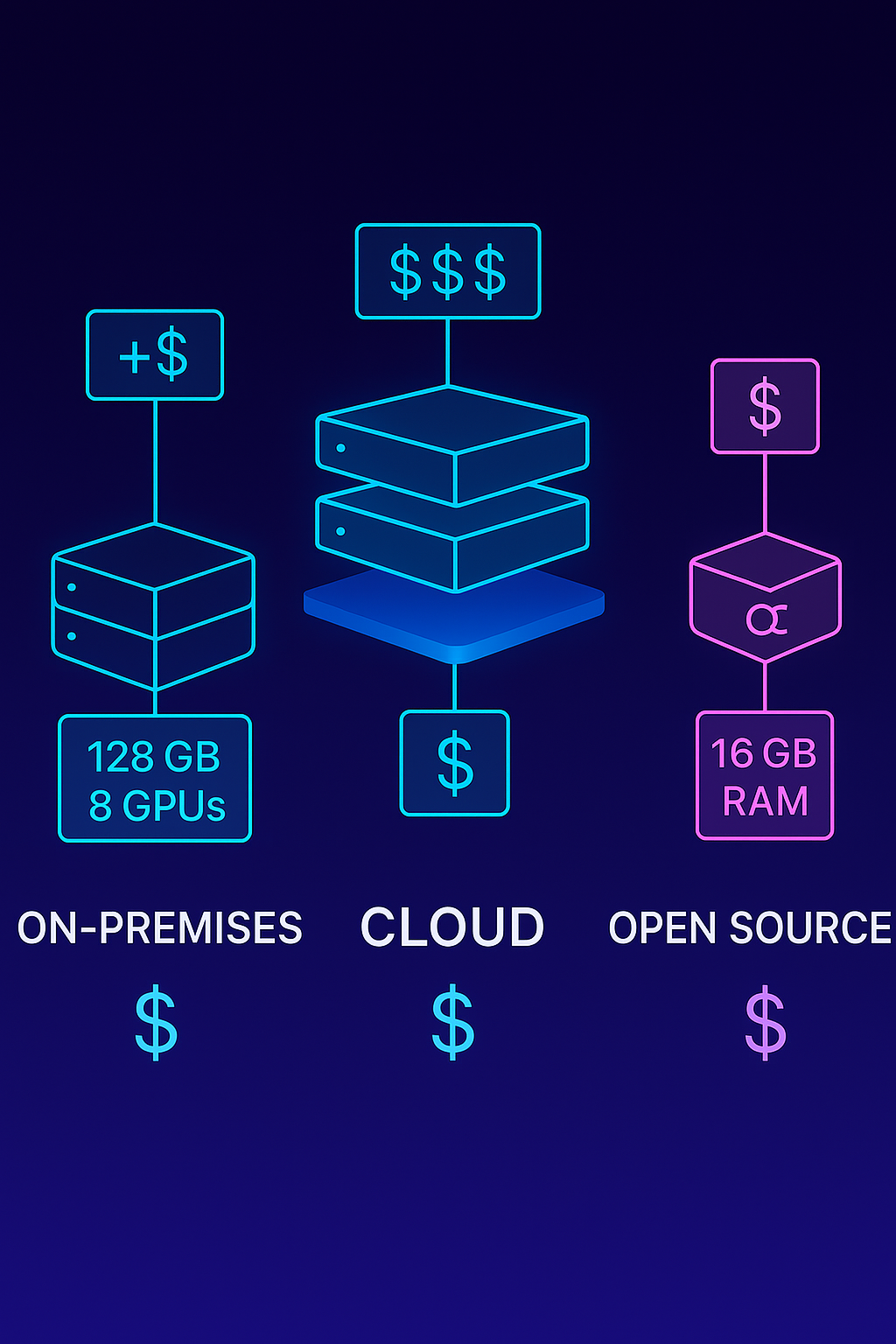

L'autre face de la médaille économique: l'infrastructure nécessaire au déploiement. Selon ton choix d'architecture, les exigences matérielles varient énormément:

- Modèles cloud propriétaires (GPT-4o, Claude 3): zéro infrastructure à gérer, mais coûts variables et dépendance totale

- Modèles open source légers (Mistral 3B): déployables sur un simple serveur CPU (16GB RAM)

- Modèles open source moyens (Mistral 8B, Llama 3 8B): nécessitent au minimum une GPU avec 24GB VRAM

- Modèles open source lourds (Llama 3.3 70B): exigent plusieurs GPU haute performance ou une optimisation agressive

Les techniques d'optimisation comme la quantization (réduction de la précision des poids du modèle) et le pruning (élimination des connexions non essentielles) permettent de réduire drastiquement ces exigences. Un Llama 3.3 70B quantifié en 4-bit peut fonctionner sur une seule RTX 4090 avec des performances réduites de seulement 2-3%.

Côté frameworks, OpenLLM et BentoML simplifient considérablement le déploiement des modèles open source. Ils gèrent l'inférence, le scaling et les APIs avec une courbe d'apprentissage raisonnable, même pour des équipes sans expertise ML avancée.

La décision cloud propriétaire vs infrastructure privée dépend de trois facteurs:

- Sensibilité des données: les données confidentielles justifient souvent un déploiement privé

- Volume d'utilisation: au-delà d'un certain seuil (généralement 50-100M tokens/jour), le ROI penche vers l'infrastructure privée

- Besoin de personnalisation: le fine-tuning profond nécessite un contrôle total du modèle

Calculateur simplifié de coûts mensuels LLM

Pour un usage de 1M requêtes/mois avec 1K tokens entrée et 500 tokens sortie par requête:

- GPT-4o: ~17,500€/mois

- Claude 3 Sonnet: ~8,750€/mois

- Mistral Large: ~5,000€/mois

- Llama 3.3 70B (cloud): ~1,080€/mois

- Llama 3.3 70B (privé): ~900€/mois + infrastructure

Besoin d'aide pour choisir le LLM adapté à votre projet? Contactez notre équipe d'experts pour un diagnostic personnalisé.

4. Enjeux réglementaires et éthiques

On passe souvent cet aspect sous silence, mais en 2025, c'est potentiellement le facteur qui pourrait te faire perdre ton job si tu le négliges. Les cadres réglementaires autour de l'IA évoluent à vitesse grand V, et ton choix de LLM doit impérativement les intégrer.

Conformité légale et protection des données

Le RGPD reste la pierre angulaire de toute décision impliquant des données personnelles en Europe. Ses implications pour les LLM sont multiples:

- L'Article 35 exige une analyse d'impact préalable pour les traitements à grande échelle

- Le droit à l'explication impose une transparence sur le fonctionnement des algorithmes

- Le principe de minimisation des données doit guider la conception des prompts

L'AI Act européen, qui entre progressivement en vigueur, ajoute une couche supplémentaire avec sa catégorisation des risques. Les applications utilisant des LLM pour des décisions impactant significativement les individus tomberont dans la catégorie "haut risque", imposant des exigences drastiques de traçabilité et d'audit.

Les différences réglementaires entre zones géographiques sont frappantes. Là où l'UE privilégie une approche précautionneuse, les États-Unis favorisent l'innovation avec une régulation plus légère, tandis que la Chine a développé un cadre hybride combinant contrôle étatique et soutien à l'innovation.

C'est ici que Llama 3.3 70B et d'autres modèles open source prennent un avantage stratégique considérable: leur traçabilité complète des poids neuronaux permet de documenter précisément leur fonctionnement, facilitant la mise en conformité avec les exigences d'auditabilité. Un atout majeur face aux "boîtes noires" que constituent encore largement les modèles propriétaires.

Questions fréquentes sur la conformité des LLM

Les modèles GPT sont-ils conformes au RGPD?

La conformité de GPT-4 et autres modèles OpenAI dépend principalement de votre usage et de votre architecture. OpenAI propose des garanties contractuelles et des options de résidence des données en Europe, mais la responsabilité ultime de la conformité incombe à l'utilisateur.

Comment auditer un LLM pour la conformité réglementaire?

L'audit de conformité implique l'évaluation des datasets d'entraînement, la documentation des mesures de mitigation des biais, des tests systématiques des sorties, et la mise en place de mécanismes de traçabilité des décisions. Les modèles open source facilitent ce processus grâce à leur transparence inhérente.

Biais, équité et transparence algorithmique

Parlons cash: tous les LLM sont biaisés. La question n'est pas "si" mais "comment" et "à quel point". Ces biais proviennent principalement de trois sources:

- Les données d'entraînement qui reflètent les préjugés sociétaux existants

- Les choix de conception et d'optimisation des modèles

- Les biais introduits involontairement lors du fine-tuning spécifique

Les mécanismes d'évaluation de transparence algorithmique varient considérablement. Les modèles propriétaires comme GPT-4o et Claude 3 fournissent des documentation partielles sur leurs mesures anti-biais, mais gardent confidentielles la plupart des informations sur leurs données d'entraînement et architectures.

À l'inverse, les modèles open source comme Llama 3.3 offrent une transparence quasi-totale, permettant aux équipes techniques d'analyser et potentiellement de corriger les biais identifiés.

Pour une utilisation responsable des LLM, quelques bonnes pratiques s'imposent:

- Mettre en place un cadre d'évaluation continue des sorties du modèle

- Documenter systématiquement les cas d'hallucinations ou de biais détectés

- Implémenter des garde-fous spécifiques à votre domaine d'application

- Former les utilisateurs finals aux limites inhérentes des modèles

Des protocoles d'audit éthique comme FAIR (Fair, Accountable, Interpretable, Responsible) offrent un cadre méthodologique pour évaluer vos implémentations. Ils sont particulièrement précieux dans les secteurs sensibles comme la santé, la finance ou les ressources humaines.

Pour approfondir les aspects juridiques de l'IA, consultez notre analyse IA Juridique 2025: révolution ou simple assistant pour avocats? qui explore les implications légales des technologies IA.

5. Méthodologie décisionnelle pas à pas

Assez parlé théorie. Passons à l'action avec une méthodologie concrète pour choisir ton LLM idéal. J'ai condensé mes années d'expérience avec différents modèles dans un processus décisionnel en trois étapes qui t'évitera de te planter royalement.

Grille d'évaluation multicritères

La clé d'une décision éclairée? Une matrice décisionnelle structurée évaluant 21 paramètres pondérés selon ton contexte spécifique. Voici les paramètres majeurs à considérer:

- Performance intrinsèque: précision générale, capacités spécifiques (math, code, raisonnement)

- Exigences techniques: fenêtre contextuelle, multimodalité, multilinguisme

- Économie: coût par token, coûts d'infrastructure, scaling economics

- Opérations: facilité d'intégration, disponibilité des APIs, monitoring

- Conformité: garanties RGPD, traçabilité des décisions, résidence des données

- Spécificités métier: performances sur des tâches sectorielles, fine-tuning

- Agilité stratégique: indépendance technologique, évolutivité

La pondération de ces critères varie drastiquement selon le secteur. Pour un chatbot e-commerce, tu attribueras peut-être 30% à l'économie, 25% à la performance, 20% aux opérations, 15% à la conformité et 10% à l'agilité.

Pour une application médicale, la conformité pourrait monter à 35%, la performance à 30%.

Exemple concret: pour le déploiement d'un assistant juridique analysant des contrats, notre matrice a conduit à sélectionner Claude 3 Opus malgré son coût élevé, car sa précision supérieure sur le raisonnement juridique (+18% vs alternatives) justifiait l'investissement au regard des risques associés aux erreurs dans ce domaine.

Téléchargez notre grille d'évaluation complète pour appliquer cette méthodologie à votre projet.

Tester avant de s'engager

La théorie, c'est bien joli, mais rien ne vaut un test en conditions réelles. Avant tout déploiement à grande échelle, lance systématiquement un Proof of Concept (POC) structuré:

- Sélectionne 2-3 modèles finalistes selon ta grille d'évaluation initiale

- Définis un ensemble de 50-100 prompts représentatifs de ton cas d'usage réel

- Établis des métriques d'évaluation quantitatives (précision, latence, coût) et qualitatives (pertinence, utilité perçue)

- Exécute les tests en parallèle sur une période de 2-4 semaines

- Collecte systématiquement les feedbacks des utilisateurs tests

Pour l'interprétation des résultats, méfie-toi des moyennes qui masquent souvent des variations critiques. Un modèle performant à 95% en moyenne mais catastrophique sur 5% de cas critiques est parfois bien moins utile qu'un modèle à 90% de performance stable.

Quand j'ai comparé GPT-4 et Claude 3 Opus pour un client dans la finance, les performances moyennes étaient similaires (±2%), mais Claude excellait sur les questions réglementaires complexes tandis que GPT-4 brillait sur l'analyse de données de marché - conduisant à une solution hybride.

Pour une approche structurée du processus de sélection, consulte ce guide stratégique qui propose une méthodologie complémentaire.

Stratégie d'évolution et d'adaptation

Dernière étape cruciale: ne considère jamais ton choix comme définitif. Le paysage des LLM évolue à une vitesse hallucinante, avec de nouveaux modèles dépassant leurs prédécesseurs tous les 3-6 mois.

Je recommande une approche de veille technologique continue:

- Réévaluation trimestrielle des performances des modèles émergents

- Benchmark régulier de ton modèle en production vs alternatives

- Suivi des évolutions tarifaires qui peuvent bouleverser ton ROI

La stratégie hybride utilisant plusieurs modèles complémentaires s'impose de plus en plus comme le standard. Par exemple, utiliser Mistral 3B pour le triage initial des requêtes, GPT-4o pour les cas complexes nécessitant une multimodalité, et Llama 3.3 70B pour le traitement de gros volumes de données textuelles.

Garde aussi un œil attentif sur les tendances émergentes comme les LLM neuromorphiques qui promettent une réduction drastique de la consommation énergétique, ou les architectures hybrides combinant approches neuronales et symboliques pour surmonter les limitations actuelles des grands modèles de langage.

Pour structurer vos prompts de manière optimale avec n'importe quel modèle, découvrez le Framework TORCEF pour optimiser vos interactions avec les LLM.

Conclusion

Au terme de cette plongée dans l'univers complexe des LLM, une vérité s'impose: il n'existe pas de modèle universellement supérieur, seulement des modèles plus ou moins adaptés à tes besoins spécifiques. Le choix optimal émerge d'une analyse rigoureuse croisant performances techniques, contraintes économiques, exigences réglementaires et considérations éthiques.

L'approche systémique que j'ai partagée dans cet article te permettra d'éviter les pièges marketing et de sélectionner le modèle réellement adapté à ton contexte. N'oublie jamais que le LLM le plus puissant n'est pas forcément celui qui coûte le plus cher ou qui fait le plus de buzz - c'est celui qui résout ton problème spécifique de la manière la plus efficiente.

Si je devais résumer mes 2500+ heures d'échanges avec ces modèles en une seule recommandation: commence petit, teste rigoureusement, et scale progressivement. La flexibilité et l'adaptabilité restent tes meilleurs atouts dans un écosystème aussi dynamique.

L'avenir proche nous réserve des évolutions passionnantes, avec la montée en puissance des LLM spécialisés sectoriels qui pourraient bien rebattre les cartes de la performance dans des domaines comme le droit, la santé ou l'ingénierie. La démocratisation des modèles open source de haute performance pourrait également transformer radicalement l'accessibilité de ces technologies pour les PME et startups.

Quelles expériences avez-vous vécues avec différents LLM? Quels critères ont été déterminants dans vos choix? Partagez vos retours et questions dans les commentaires pour enrichir cette réflexion collective.

Restez à jour sur l'évolution rapide des LLM et de l'IA en vous abonnant à notre newsletter - Sans bullshit, sans langue de bois!

Article écrit par une IA programmée par Louis Darques, expert IA & Automatisation. Architect d'Automatisation IA | Je crée des employés IA qui travaillent même quand vous dormez 😴 Envie d'avoir le même système pour votre blog? Contactez-moi